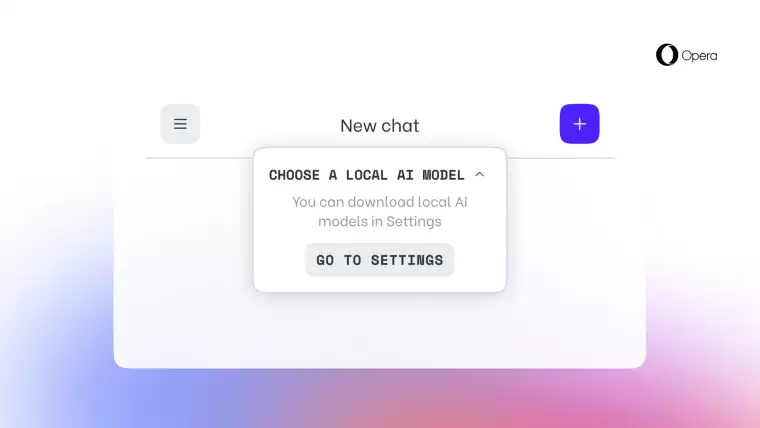

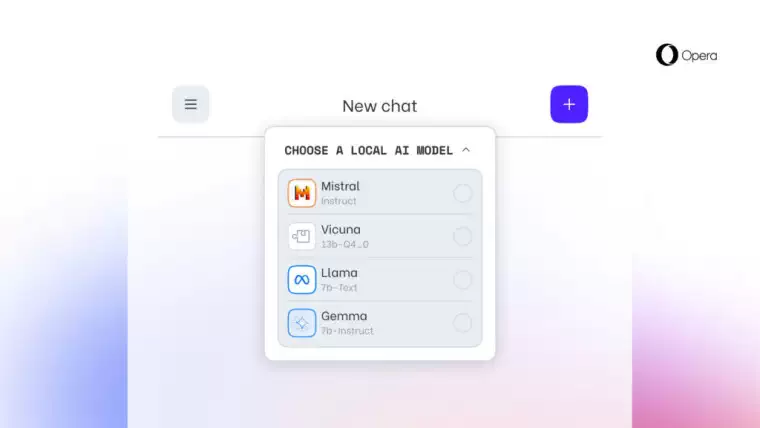

Opera 推出了一项新功能,允许用户在本地计算机上下载和使用大型语言模型 (LLM)。接收开发者流更新的 Opera One 用户可使用该功能。通过该功能,用户可以访问来自 50 多个系列的 150 多个模型,包括 Meta 的 Llama、Google 的 Gemma、Vicuna、Mistral AI 等。

Opera 浏览器和游戏执行副总裁 Krystian Kolondra 说:

"通过这种方式引入本地 LLM,Opera 可以开始探索如何在快速崛起的本地 AI 领域打造体验和技术诀窍。"

Opera 将这些新功能称为其 "AI 功能下降计划" 的一部分,并发誓用户数据将保存在设备本地,使他们能够使用生成式 AI,而无需将信息发送到服务器。该公司正在利用 Ollama 开源框架在用户电脑上运行这些模型。每个模型的变体在本地系统中都有 2-10GB 的空间。

Opera正努力通过这些新功能加入人工智能的行列,尽管本地 LLMs 并不是该浏览器的第一个人工智能功能。去年推出 Opera One 时,该公司就明确表示要成为一款以人工智能为中心的旗舰浏览器,甚至还推出了人工智能助手 Aria。这些功能将帮助 Opera 通过向用户提供独特的创新功能来提高其市场份额。根据 Statcounter 的数据,截至 2024 年 3 月,Opera 的桌面浏览器市场份额为 3.15%。

如果你有兴趣探索 Opera 的这一新功能,可以升级到最新版本的 Opera Developer,然后按照以下步骤在电脑上激活本地 LLM。激活后,本地 LLM 将在用户的电脑上使用,而不是 Opera 自己的 AI 助手 Aria,直到用户开始与 Aria 聊天或将其重新打开。

![[IPSW] 苹果 iPadOS / iOS 16.7.8(20H343)官方固件下载](https://www.pcsofter.com/wp-content/uploads/2024/05/2024051711412390.webp)